Trends & Analyse

ChatGPT - die Büchse der Pandora?

Künstliche Intelligenz bietet immer mehr Möglichkeiten - allerdings auch für Cyberkriminelle. Doch welche Gefahren gehen von ChatGPT & Co. für die IT-Sicherheit aus?

Bild: Shutterstock / dps studio

Bild: Shutterstock / dps studio

Er ist momentan der absolute Superstar in der KI-Branche: ChatGPT. Der im November vergangenen Jahres vom Unternehmen OpenAI veröffentlichte Chatbot gilt als Meilenstein der Künstlichen Intelligenz und wird häufig sogar mit der Einführung des iPhones oder Suchmaschine Google verglichen. Mit Hilfe des Generative Pre-trained Transformer, so der ausführliche Name von ChatGPT, können zum ersten Mal auch weniger Technikaffine mit einer KI interagieren und zum Beispiel Businesspläne, Computer-Code oder Gedichte verfassen lassen.

Doch wie immer, wenn es neue Technologien gibt, hat alles seine zwei Seiten - und meistens ist eine davon eine Schattenseite. Denn mittlerweile loten auch immer öfters Cyberganoven aus, inwieweit sich der Chatbot für kriminelle Zwecke einsetzen lässt, etwa für den Angriff auf Unternehmensnetze.

Sind moderne KI-Systeme also mehr Fluch als Segen - und öffnen damit die Büchse der Pandora für die IT-Sicherheit? Nun wurde etwa ChatGPT nicht wie Pandora vom Göttervater Zeus als Strafe für die Menschheit erschaffen, aber macht aktuelle und moderne KI die Sicherheit der IT-Infrastruktur überhaupt noch beherrschbar?

Alles hat seine zwei Seiten

Das iPhone habe sicher einen enormen Innovationsschub ausgelöst, doch Künstliche Intelligenz sei zweifellos noch eine andere, größere Dimension, konstatiert Frank Reiländer. „Dafür das Bild von der ,Büchse der Pandora’ zu verwenden, halte ich jedoch für problematisch, weil es einseitig auf die potenziellen negativen Folgen ihrer Anwendung zielt“, so der Head of Cybersecurity beim IT-Dienstleister CGI. Fortschritt sei ihm zufolge immer Janus-köpfig - und er stellt damit den Vergleich mit dem römischen Gott des Anfangs und des Endes an, den früheste Abbildungen mit einem Doppelgesicht zeigen. Reiländer zufolge komme es darauf an, wie man die neue Technologie einsetzt. "Ähnliche Diskussionen hatten wir - wer sich noch erinnert - beim Klon-Schaf Dolly. Es geht also wieder einmal um die Vereinbarung und Einhaltung gesetzlicher und ethischer Regelungen für die Nutzung einer neuen Technologie."

Roger Scheer gibt zu bedenken, dass derzeit viel über ChatGPT und generative KI im Allgemeinen gesprochen werde, was Auswirkungen sowohl auf Cyber-Verteidiger als auch auf Cyber-Angreifer habe. "Die Wahrheit ist, dass generative KI wie Google Translate ist, und wie Sie es verwenden, wird das Ergebnis beeinflussen", erklärt der Regional Vice President of Central Europe beim Sicherheitsunternehmen Tenable. "Was wir wissen, ist, dass generative KI äußerst effektiv darin ist, extrem komplexen Maschinen-Code in verständliche Sätze zu übersetzen, die der Laie verstehen kann. Und das sind sowohl gute als auch schlechte Nachrichten für Cyber-Verteidiger." Aber auch er bestätigt, dass aus Sicht der Bedrohungsakteure die Eintrittsbarriere erheblich verringert werde, da Angreifer Software zurückentwickeln und Schwachstellen schnell identifizieren können. Doch für Verteidiger könne es genauso eingesetzt werden, um Schwachstellen zu ermitteln, die angegangen werden müssen.

"KI-gestützte Phishing-Betrügereien und Bedrohungsakteure, die ChatGPT zum Schreiben von bösartigem Code verwenden, sind Angriffe, die heute stattfinden."

Die Macher von ChatGPT nehmen für sich zwar in Anspruch, böswillige Eingaben und Reaktionen aktiv zu bekämpfen. Das muss man erst einmal so glauben - denn was die KI wirklich macht und was unter der Haube passiert, das lässt sich nur schwer überprüfen

"Cyberkriminelle loten die Möglichkeiten von ChatGPT & Co. derzeit natürlich aus", erklärt Christian Lueg, Sicherheitsexperte DACH bei Eset. Dennoch seien die aktuellen Gefahren seiner Ansicht nach derzeit überschaubar. Sicherlich werde KI in der Cyberkriminalität zukünftig eine größere Rolle spielen. "Das bedeutet nicht, dass es neue Angriffsarten kommen wird, aber es wird eine noch bessere Täuschung der Opfer und eine höhere Effizienz durch die Automatisierung der Angriffe möglich sein. Daher kommt auf die Unternehmens-IT keine neuen Gefahren zu, eher wird es noch wichtiger Mitarbeiter für die IT-Sicherheit zu sensibilisieren." Nicht erst seit gestern sei laut Lueg die Idee der Künstlichen Intelligenz beziehungsweise des Maschinellen Lernens in aller Munde. "Es kommt darauf an, worüber wir sprechen und was wir meinen. ML-basierte Technologien gibt es bereits seit den 90er-Jahren des letzten Jahrhunderts." ChatGPT habe eine solche Entwicklung nicht angestoßen, sondern lediglich der Öffentlichkeit demonstriert, was in der Wissenschaft schon längst diskutiert wird.

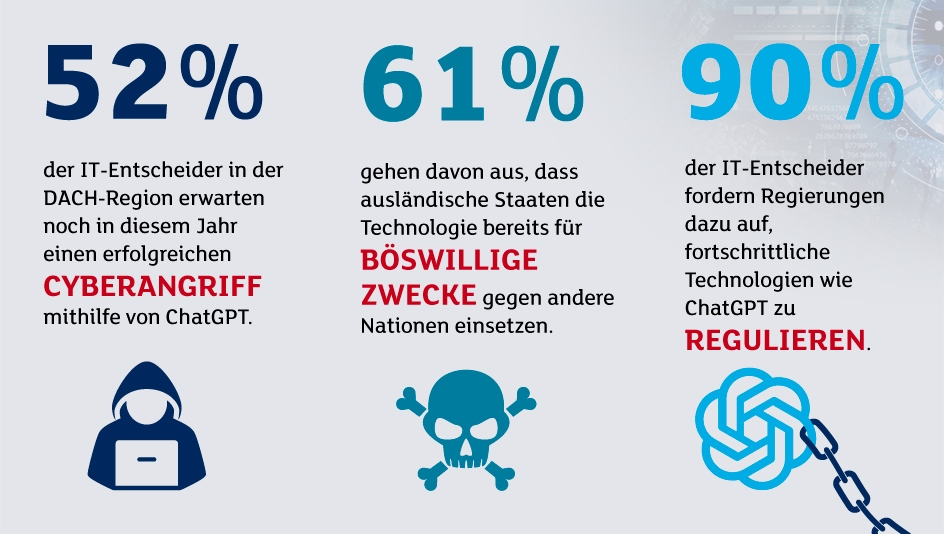

Quelle: BlackBerry/OnePoll, Januar 2023

Sergej Epp, Chief Security Officer, Central Europe bei Palo Alto Networks, ordnet ChatGPT & Co. wie folgt ein: "Historisch gesehen waren Kriminelle immer die ersten, die sich neue Innovationen zu eigen machten: Angefangen mit dem Aufkommen des Automobils, das es den Strafverfolgungsbehörden zu Fuß oder zu Pferd schwermachte, Schritt zu halten, über den Missbrauch von E-Mails zum Versenden von Spam bis hin zum Missbrauch von Kryptowährungen für Geldwäsche oder Lösegeldzahlungen." Er fragt sich, warum es dieses Mal anders sein sollte. Der einzige Unterschied bestehe darin, dass mit generativer KI die Möglichkeiten im Vergleich zu diesen Beispielen tausendmal größer sind.

Epp betont aber auch: "Was die Bedrohungslandschaft angeht, so werden Kriminelle zu Superkriminellen, da sie tausendmal produktiver werden." Man solle sich nur einmal das Aufkommen von KI-Assistenten vorstellen, die einzelne Kriminelle befähigen, auf der Ebene von Nationalstaaten zu agieren. Gleichzeitig werde es eine Flut neuer Krimineller geben, die in der Vergangenheit nicht geschickt genug waren, um auf die dunkle Seite zu wechseln.

Konkrete Gefahren für die IT-Sicherheit

Wenn man wissen will, was mit einer Künstlichen Intelligenz in Bezug auf Cyberangriffe alles möglich ist, muss nur ein paar Jahre zurück gehen. Die Cyber Grand Challenge der DARPA zeigte bereits im Jahr 2016, dass KI fast den gesamten Lebenszyklus eines Cyberangriffs simulieren kann. Die Defense Advanced Research Projects Agency, kurz DARPA, ist eine Behörde des US-Verteidigungsministeriums. Bei der Challenge traten verschiedene Software-Systeme gegeneinander an, deren Aufgabe es war, Sicherheitslücken zu finden und auszunutzen.

Eine der Hauptgefahren, die von moderner Künstlicher Intelligenz wie ChatGPT ausgeht, ist jedoch das Thema Vertrauen - und wie damit umzugehen ist. Wir sind es gewohnt, viele Dinge als authentisch und damit vertrauenswürdig wahrzunehmen. Das geschieht quasi automatisch, ohne viel nachzudenken. Doch der Gültigkeitsbereich für diesen natürlichen Vertrauensvorsprung werde nach Ansicht von Frank Reiländer durch die neuen KI-Technologien drastisch eingeschränkt. "Wir alle müssen das Bewusstsein dafür schärfen, genauer hinzusehen und Authentizität und Originalität zu prüfen, so wie es mit dem Zero-Trust-Ansatz eingeführt wurde." Im Bereich der Cybersicherheit spreche man dabei von dem Umgang mit Risiken, die im Rahmen eines sinnvollen Risiko-Managements auf ein tolerierbares Maß reduziert werde.

Künstliche Intelligenz kann beispielsweise dazu genutzt werden, Phishing-Mails echten Mails noch besser anzugleichen, potenzielle Opfer damit gezielter zu täuschen und so die Nutzungsrate zu erhöhen. "ChatGTP hat Kriminelle innerhalb eines Tages buchstäblich mit Superkräften für ihre Phishing-Kampagnen ausgestattet", so Sergej Epp von Palo Alto Networks. Jetzt könnten sie jeden erdenklichen Kanal wie E-Mail, Sprache oder soziale Medien in mehreren Sprachen nutzen, "zugeschnitten auf die aktuelle Situation jeder Zielperson und unter Ausnutzung ihrer individuellen kognitiven Neigungen." Dies sei die perfekte Waffe, um Menschen zu ködern oder zu manipulieren.

Exkurs: Europol nimmt ChatGPT unter die Lupe

Auch die europäische Polizeibehörde Europol hat die Auswirkungen von ChatGPT auf die Cybersicherheit untersucht - und macht sich Sorgen. Experten im Europol Innovation Lab ermittelten, wie Kriminelle sogenannte Large Language Models (LMMs) wie ChatGPT missbrauchen können.

LMMs sind Künstliche-Intelligenz-Systeme, die Text verarbeiten, manipulieren und generieren. Beim Training dieser Systeme werden große Datenmengen wie Bücher, Artikel und Webseiten eingespeist, damit es die Muster und Verbindungen zwischen Wörtern lernen kann, um neue Inhalte zu generieren.

Da die Fähigkeiten dieser KI-Systeme stetig verbessert werden, sieht Europol hier düstere Zeiten auf die IT-Security zukommen. Die Möglichkeit von ChatGPT zum Beispiel sehr realistische Texte zu verfassen, mache es zu einem nützlichen Werkzeug für Phishing-Zwecke.

Die Fähigkeit Sprachmuster nachzubilden, könne genutzt werden, um den Sprachstil bestimmter Personen oder Gruppen zu imitieren.

Und die Möglichkeit, Code in einer Reihe verschiedener Programmiersprachen zu generieren, sei für Kriminelle mit geringen technischen Kenntnissen eine unschätzbare Ressource, um bösartigen Code zu erzeugen.

Auch Sohrob Kazerounian sieht etwa Phishing als unmittelbare Gefahr durch KI-Systeme. "Die Verwendung von Sprachmodellen macht es relativ einfach, etwa Spear-Phishing in großem Umfang zu automatisieren, mit Angriffen, die automatisch auf die Interessen und den Hintergrund eines bestimmten Benutzers abgestimmt sind." Bei Verwendung für diese Art von Spear-Phishing könnten Angreifer qualitativ hochwertige gezielte Angriffe generieren, denen ein Opfer mit größerer Wahrscheinlichkeit zum Opfer fällt, ohne dass ein wirklicher manueller Aufwand erforderlich sei. "Darüber hinaus kann Künstliche Intelligenz, die Deep Fakes und Klon-Stimmen erzeugen kann, leicht für Social Engineering und Betrug eingesetzt werden, wiederum mit sehr geringem Aufwand seitens eines Angreifers."

In jüngerer Zeit, in denen Machine Learning und Künstliche Intelligenz in unserem Leben allgegenwärtig geworden sind, müssten sich laut Kazerounianauch auf ganz neue Gefahren einstellen: "Beispielsweise haben viele Mitarbeiter ChatGPT verwendet, um einige Aspekte ihrer Arbeit zu automatisieren, wobei einige Berichte zeigen, dass 4 Prozent der Mitarbeiter möglicherweise bereits versucht haben, sensible Daten an den Dienst zu senden. Das Thema Datenschutz spielt also hier ebenfalls eine große Rolle."

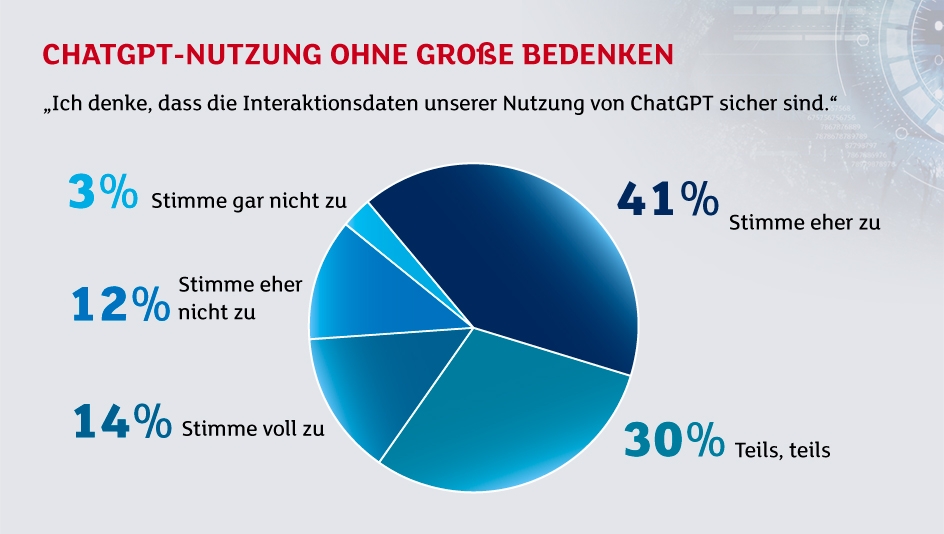

Quelle: Adesso, "ChatGPT in Unternehmen - Spielzeug oder Game Changer?"

In dieselbe Kerbe schlägt Michael Elbel. Er ist Leiter Interne Technik bei Consol Software in München. Unbedarfte Nutzer seien sich möglicherweise der Tragweite ihrer Interaktionen mit ChatGPT nicht bewusst. Daher seine Warnung: "OpenAI verwendet alles weiter, was der Chatbot an Input erhält - auch sensible Informationen.“ Dieses Bewusstsein fehle Nutzern aufgrund der spielerischen Kommunikation mit der Anwendung oft. OpenAI warne in den Nutzungsbedingungen zwar selbst, dass Nutzer sensible Informationen keinesfalls teilen sollten, "aber wer liest schon AGBs?".

Wie brisant das Thema Datenschutz etwa bei ChatGPT ist, zeigt das Beispiel Italien: Die dortige Datenschutzbehörde sperrte den KI-Dienst von OpenAI vorübergehend im März. Die Begründung: Es gebe keine Rechtsgrundlage für die massenhafte Sammlung und Speicherung personenbezogener Daten zum Zwecke des Trainings der Algorithmen. Und auch die deutschen Datenschutzbehörden haben ChatGPT auf dem Radar: Wie der "Tagesspiegel" berichtet, wollen deutsche Behörden das Geschäftsgebaren von OpenAI wegen möglicher Datenschutzverletzungen beim Training der Künstlichen Intelligenz untersuchen.

"Wir stehen heute bei weitem nicht vor einer KI-Apokalypse für die IT-Sicherheit."

KI-generierte Malware?

Auch wenn ChatGPT programmieren kann - Angst vor einer Malware-Flut, programmiert von einer Künstlichen Intelligenz, muss man wohl erst einmal nicht haben. ChatGPT ist nur sehr eingeschränkt in der Lage, Malware zu schreiben. Bei Einführung des Textbots wurde das Internet regelrecht geflutet von "Malware", die damit erzeugt wurde. Diesem Phänomen wurde zwischenzeitlich ein ziemlich effektiver Riegel vorgeschoben.

Im Gegensatz zu ChatGPT kennt ein erfahrener Cybergauner das Profil seines potenziellen Ziels ziemlich genau. Bei mehreren Tests habe sich laut Martin Holste, CIO Cloud bei Trellix, herausgestellt, dass die ChatGPT-Malware fehlerhaft war oder von Sicherheitslösungen sofort erkannt wurde – "ein Beleg für den Mangel an Kreativität und Individualität, ohne die Cyberattacken heutzutage nicht mehr funktionieren".

Dennoch: Vereinfacht wird die Arbeit der Cyberkriminellen mit den Programmier-Fähigkeiten von ChatGPT durchaus. Zu den Stärken von ChatGPT gehört das Schreiben von sogenannten Code-Snippets. Auch erlaubt das Tool Angreifern, Code-Schwachstellen schneller auszunutzen oder hierfür eine Programmiersprache zu verwenden, mit welcher der Angreifer selbst nicht vertraut ist.

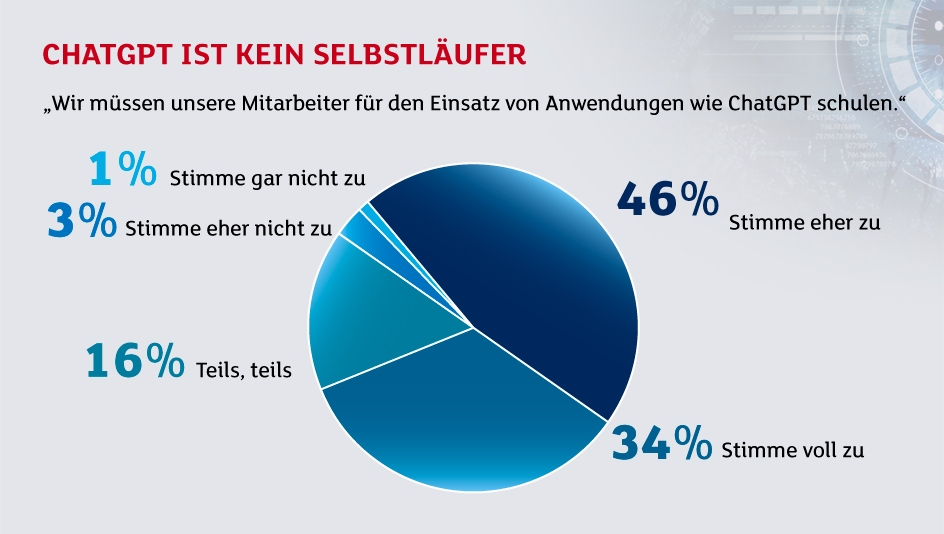

Quelle: Adesso, "ChatGPT in Unternehmen - Spielzeug oder Game Changer?"

ChatGPT als Chance

Um beim Bild des Gottes Janus mit seinen zwei Blickwinkeln zu bleiben - moderne KI-Systeme wie ChatGPT bieten neben den Risiken durchaus auch Chancen für die IT-Sicherheit. Angreifer haben in der Regel den Vorteil, dass sie den ersten Zug machen können. Die Anbieter von IT-Sicherheits-Tools reagieren dann entsprechend darauf und müssen sich an die neuen sogenannten TTPs (Techniques, Tactics and Procedures) der Kriminellen anpassen.

Sind also nur moderne, KI-gestützte IT-Sicherheitssysteme gegen KI-Angriffe sicher - und wir erleben ein Wettrüsten von guter KI gegen böser KI? "Das ist selbst für einen Sechsjährigen klar", so die deutliche Aussage von Sergej Epp. "Nur Maschinen können Maschinen in ihrer Geschwindigkeit und in ihrem Ausmaß bekämpfen."

Laut Frank Reiländer sei die Frage nach dem Wettrüsten jedoch gar nicht so einfach zu beantworten. "Klar ist: Wenn Angriffe immer raffinierter werden und altvertraute Wahrheiten keinen Bestand mehr haben, muss man umso genauer hinschauen." Dabei sei das Finetuning wichtig. Ob das dann nur mit KI-gestützten Werkzeugen möglich sein wird, sei nicht leicht zu beantworten. "Wer hat schon, um ein Beispiel aus der analogen Welt zu nehmen, alle Sicherheitsmerkmale einer Euro-Banknote im Kopf und könnten diese auch erkennen? Trotzdem nutzen wir sie täglich." Professionelle Nutzer, wie etwa eine Kassiererin oder ein Tankwart, würden dafür ein kleines Prüfgerät mit automatischem Einzug und hochauflösender Erkennung einsetzen. Der entscheidende Vorteil sei stets die Geschwindigkeit und Skalierbarkeit der Tools.

"Die beste Firewall ist immer noch das menschliche Gehirn. Es gilt also, das Bewusstsein für die Gefahren zu schärfen."

Michael Elbel von Consol gibt zu bedenken, dass dieses Wettrüsten zwischen Angreifern und der Gefahrenabwehr bereits seit Jahrzehnten im Gange sei. KI sei lediglich die neueste Technik, die IT-Sicherheitsexperten und Hacker instrumentalisieren. Und sie werde auch nicht die letzte bleiben. "Grundsätzlich ist Künstliche Intelligenz aber wertneutral: Der Mensch entscheidet, wie gut oder böse sie ist."

Den großen Vorteil von Künstlicher Intelligenz sieht Frank Schwaak, Field CTO EMEA bei Rubrik, darin, dass sie auch von White-Hat-Hackern genutzt werden könne. White-Hat-Hacker sieht mietbare Hacker, die IT-Strukturen von Unternehmen hacken, um sicherzustellen, dass diese keine Sicherheitslücken aufweisen. "Diese identifizieren - in friedlicher Absicht - durch automatisiertes Pen-Testing die Schwachstellen in Systemen und helfen damit, die erkannten Lücken zu schließen, bevor Angreifer die Schwachstellen ausnutzen können."

Konkrete Schutzmaßnahmen

Für Unternehmen gibt es bereits eine Reihe von Maßnahmen, die sie bereits heute umsetzen können, um sich vor den steigenden Gefahren von KI-Systemen zu wappnen.

Als konkretes Beispiel nennen Frank Reiländer von CGI einen Klassiker der Defence-in-Depth-Strategie: "Die beste Firewall ist immer noch das menschliche Gehirn. Es gilt also das Bewusstsein für die Gefahren zu schärfen. In vielen Unternehmen passiert das bereits." Dafür würden beispielsweise im Rahmen von Awareness-Kampagnen simulierte Phishing-Mails versendet. Wer sie öffnet, landet auf einem Server mit Trainingsangeboten. Solche präventiven Aktivitäten müssten ausgebaut werden, um nicht nur gefälschte Mails, sondern auch die Echtheit von Dokumenten zu erkennen. Dazu müssten die Kenntnisse geschult werden, wie ein von einer Person geschriebener Text von einem ChatGPT-Elaborat zu unterscheiden ist.

"Wir sollten jedoch nicht auf eine Kennzeichnungspflicht von ChatGPT-Dokumenten setzen", führt Reiländer weiter aus. Das sei keine Lösung, "weil Straftäter dummerweise nur höchst selten ein ausgeprägtes Regelbewusstsein besitzen." Wir befänden uns vielmehr in einer Art Wettrüsten, oder besser gesagt Wettlauf. "Jeder Fälscher hat seine Handschrift, jeder Drucker feine Typenmerkmale. Das gilt ähnlich auch für ChatGPT-Texte. Ihre Fingerabdrücke müssen genommen, und die Heuristik für ihre Erkennung ständig angepasst werden - ähnlich wie ein Virenscanner, der mit regelmäßigen Signatur-Updates aktuell bleibt."

"OpenAI verwendet alles weiter, was der Chatbot an Input erhält - auch sensible Informationen."

Martin Holste von Trellix empfiehlt Unternehmen folgende drei konkreten Tipps, die sie bereits heute umsetzen können, um mit ChatGPT gefahrlos die Produktivität zu steigern und KI-basierte Angriffe abzuwehren:

- Datenschutz: Die Endpunkte sollten mit entsprechender Technologie ausgestattet werden, die kontrolliert, welche Daten in ChatGPT eingespeist werden

- Protokollierung: Unternehmen sollten für eine maximale Visibilität ihrer Geschäftsanwendungen und -infrastruktur sorgen. Dazu sollten hierfür Aktivitäts- und Audit-Protokolle der Geräte und SaaS-Anwendungen erfasst werden und diesen den Sicherheitsexperten und KI-Lösungen zur Verfügung stehen

- KI zur Cyberabwehr: Sicherheitsteams sollten mit Tools ausgestattet werden die ebenfalls Künstliche Intelligenz nutzen, um Cyber-Angriffe zu bekämpfen

Des Weiteren, so Martin Holste, sollten ergänzend regelmäßige Schulungen nicht nur der Sicherheitsprofis stattfinden, sondern der gesamten Belegschaft. Gerade dies komme oft zu kurz, sei aber für einen effektiven Schutz von entscheidender Bedeutung.

Fazit & Ausblick

Eines ist in jedem Fall sicher: Das ewige Katz-und-Maus-Spiel zwischen Cyberkriminellen und den IT-Sicherheitsexperten geht weiter. Hochspezialisierte Angreifer lassen sich immer neue Methoden einfallen, auf die ihre Gegenspieler mit Schutz- und Präventivmaßnahmen reagieren. Für eine effektive Abwehr braucht es daher weitreichende Kenntnisse der IT-Sicherheit und entsprechend fortschrittliche Technologien.

Auch wenn das aktuell bekannteste KI-Beispiel ChatGPT erst seit dem vergangenen Jahreswechsel so richtig bekannt ist - bei den Gefahren durch Künstliche Intelligenz für die IT-Sicherheit geht es keinesfalls um Zukunftsmusik. Die Gefahr ist bereits heute real – Künstliche Intelligenz und deren Folgen wird in zahllosen Beiträgen, Diskussionen und Foren rauf- und runter dekliniert. Und auch die Cyberkriminellen setzen sich damit umfangreich auseinander. Das zeigt zum Beispiel eine Untersuchung des VPN-Dienstleisters NordVPN: Die Zahl der neuen Beiträge in Dark-Web-Foren über das KI-Tool ChatGPT stieg von 120 im Januar auf ganze 870 im Februar.

Auch Roger Scheer von Tenable bestätigt, dass die Gefahr bereits Realität ist - und es wahrscheinlich noch schlimmer werde. "KI-gestützte Phishing-Betrügereien und Bedrohungsakteure, die ChatGPT zum Schreiben von bösartigem Code verwenden, sind Angriffe, die heute stattfinden." Die Sorge sei, dass wir erst begonnen haben, an der Oberfläche möglicher böswilliger Anwendungsfälle zu kratzen.