Kommentare

EU AI Act: Arctic Wolf, Carmao, Confluent, Dynatrace

Der EU AI Act hat wegen seiner gewaltigen Auswirkungen auf den Markt für Künstliche Intelligenz zahlreiche Reaktionen von Unternehmern und Analystenhäusern hervorgerufen. Dieser Beitrag fasst die Einschätzungen des Security-Operations-Spezialisten Arctic Wolf, des Beratungshauses Carmao, der Datenstreaming-Plattform Conflunet und des Observability-Anbieters Dynatrace zusammen.

Bild: Shutterstock / CoreDesign

Bild: Shutterstock / CoreDesign

Arctic Wolf: Ein wichtiger Schritt zur Förderung der KI-Technologie

Dan Schiappa, AI Evangelist und Chief Product Officer bei Arctic Wolf, einem führenden Anbieter von Security Operations, hat sich Gedanken dazu gemacht, was die Entscheidung für den AI Act für die Cybersicherheit bedeutet. Sein Urteil lautet: „Die KI-Verordnung des Europäischen Parlaments (AI Act) ist ein wichtiger Schritt, die Entwicklung dieser bedeutsamen Technologie zu fördern, ohne die Privatsphäre und persönlichen Rechte der Menschen zu beschneiden.“

Schiappa findet es gut, dass die EU-Gesetzgebung wie eine Art KI-Verfassung, die Regierungen und Wirtschaft daran hindern soll, die Freiheiten von EU-Bürgerinnen und Bürgern einzuschränken. Er hält den Beschluss der EU, bei der KI-Regulierung zuerst die Bürgerrechte zu berücksichtigen, für einen wichtigen ersten Schritt. „Dieses Vorgehen schränkt zudem nicht ein, wie KI für kritische Geschäftsfunktionen wie Automatisierung, intelligentere Entscheidungsfindung und – meiner Meinung nach einer der wichtigsten Aspekte – im Bereich der Cybersicherheit eingesetzt werden kann.“ Er resümiert: „Mir gefällt dieser Ansatz, und ich würde andere Länder ermutigen, dem Beispiel der EU zu folgen.“

„Der AI Act ist ein wichtiger Schritt, die Entwicklung dieser bedeutsamen Technologie zu fördern, ohne die Privatsphäre und persönlichen Rechte der Menschen zu beschneiden.“

Schiappa weist darauf hin, dass sich die meisten Gesetze und Verordnungen in erster Linie darauf zu konzentrieren scheinen, KI-Kriminalität und Cyberbetrug einzudämmen, so etwa in den USA. Das sei zwar wichtig, doch wüsten wir auch, dass sich Kriminelle und Bedrohungsakteure nicht an Gesetze halten. Aus dieser Erkenntnis folgert er: „Den Fokus auf den Schutz der Rechte des Einzelnen und das Recht auf Privatsphäre zu legen, ist daher eine bedeutende erste Etappe auf dem Weg hin zu einer KI, die einen positiven gesellschaftlichen Effekt hat.“

CARMAO: Ein Risikomanagementsystem ist künftig Pflicht

Die 2003 gegründete CARMAO GmbH aus Limburg a. d. Lahn bietet Beratung, Projektdurchführungen, Dienstleistungen und Seminare an mit Schwerpunkten wie organisationale Resilienz nach ISO 22316, Informationssicherheit, Risikomanagement, Business Continuity Management (BCM), Datenschutz und Compliance. In seinem Statement zum AI Act nimmt Carmao speziell die Herausforderungen für die Anbieter von KI-Systemen in den Blick.

Diese Anbieter seien verpflichtet, ein Risikomanagement-System einzuführen und Anforderungen in puncto Datenqualität und -integrität zu erfüllen. Dabei kämen zahlreiche administrative Anforderungen auf sie zu, wie zum Beispiel die Sicherstellung von Qualität, (technischer) Dokumentation und proaktiver Information. Ulrich Heun. Geschäftsführender Gesellschafter von Carmao empfiehlt deshalb: „Zur Erfüllung des AI-Act braucht es ein KI-Managementsystem nach ISO 42001. ISO ermöglicht die Umsetzung der geforderten Transparenz, Rechenschaftspflicht und Sicherheitsstandards für KI-Technologien.“

.jpg)

„Zur Erfüllung des AI-Act braucht es ein KI-Managementsystem nach ISO 42001.“

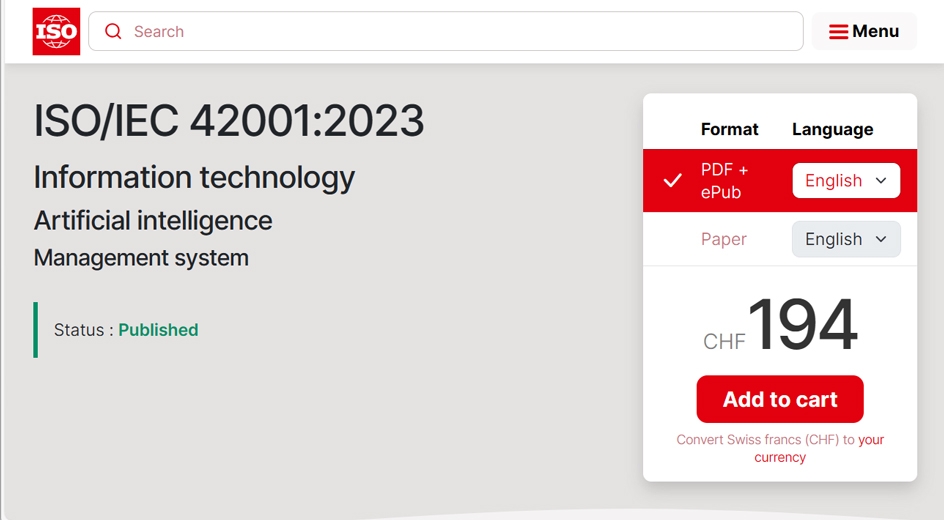

Für Heun spielt die die ISO-Norm 42001 für die Konformität mit dem AI-Act eine maßgebliche Rolle. „Die Norm bietet sowohl Anbietern als auch Anwendenden einen umfassenden Rahmen für die Entwicklung, Bereitstellung und verantwortungsvolle Nutzung von KI-Systemen“ – und ermögliche es Unternehmen, mit dem EU-KI-Gesetz und anderen relevanten Vorschriften in Einklang zu sein und potenzielle schwerwiegende Strafen zu vermeiden.

Ulrich Heun, CEO von Carmeo, empfiehlt Unternehmen, sich ein KI-Managementsystem nach der ISO 42001 zuzulegen. Ein Anfang wäre schon mal, sich das Paper von 2023 mit den entsprechenden Bestimmungen von der Website des Normierungsgremiums für 194 Franken herunterzuladen.

Confluent: Ganzheitlicher Umgang mit Daten

Confluent ist bekannt für seine umfassende cloud-native Daten-Streaming-Plattform. Zum EU AI Act hat Peter Pugh-Jones, Director of Financial Services, Confluent, einen Kommentar abgegeben. Er fragt, ob wir gerade „den europäischen Durchbruch im richtigen Umgang mit KI erleben“ und nimmt als Antwort die Unternehmen selbst in die Pflicht: „Trotz KI-Gesetzgebung liegt es an den Unternehmen selbst, ihre eigene Daten-Governance sorgfältig zu überprüfen, insbesondere wenn es um den Einsatz von großen Sprachmodellen (Large Language Models, LLMs) geht. Nur so können sie sicherstellen, dass KI nicht nur ethisch verantwortungsvoll, sondern auch sicher und gewinnbringend eingesetzt wird.“

Für Pugh-Jones stehen den Vorteilen der KI wie der stärkeren Automatisierung, dem optimierten Kundenservice und der Reduzierung von Kosten und Ressourcen aber auch technologie-bedingte Gefahren gegenüber. „Kommt es zu einem Ausfall oder einer Kompromittierung der Systeme, kann der potenzielle Schaden immens sein“, warnt Pugh-Jones und fordert: „Deshalb müssen Unternehmen darauf achten, dass ihre Pläne für die Ausfallsicherheit ihrer Systeme und die Wiederherstellung im Schadensfall noch gründlicher konzipiert und mit Fallback-Lösungen versehen werden. Verfügbare Cloud-Dienste können dabei helfen, die nötige Sicherheit zu gewährleisten.“

„Trotz KI-Gesetzgebung liegt es an den Unternehmen selbst, ihre eigene Daten-Governance sorgfältig zu überprüfen“

Die Verantwortung für den richtigen Einsatz von KI im Unternehmen sieht Pugh-Jones letztendlich als Aufgabe der CISOs, CTOs und CDOs an. Gemeinsam müssten sie einen ganzheitlichen Ansatz für den Umgang mit Daten und KI-Governance als Teil der strategischen Roadmap für das Unternehmen definieren. Der EU AI Act ist ihmzufolge ein wichtiger Schritt, der jedes Unternehmen dazu bewegen sollte, den individuellen Umgang mit KI gründlich zu definieren und zu prüfen. Dies könne mit der Einführung von Funktionen wie Daten-Streaming-Plattformen unternehmensweit und transparent durchgeführt werden. Er prognostiziert: „Die Realität ist, dass Unternehmen, die sich nicht an die Erwartungen von Kunden und Behörden anpassen, den Anschluss verpassen werden."

„Die Realität ist, dass Unternehmen, die sich nicht an die Erwartungen von Kunden und Behörden anpassen, den Anschluss verpassen werden.“

Dynatrace: Kategorisieren und prüfen

Dynatrace ist einer der führenden Anbieter von Unified Observabilty und Security. Bernd Greifeneder, CTO und Gründer von Dynatrace, stellt in seinem Statement zur Entscheidung des EU-Parlaments zum AI Act die für die zweijährige Übergangszeit akut ergebenden To-Dos für Unternehmen in den Mittelpunkt.

Dabei geht Greifeneder von der Einschätzung aus, dass die festgelegten Leitlinien nahelegen, dass die EU „verständlicherweise den Schwerpunkt ihrer Regulierung auf die Verringerung geopolitischer Risiken von KI gelegt hat, nicht aber auf Geschäftsrisiken“. Deshalb erwartet Greifender, dass die meisten Unternehmen für ihre KI-Anwendungen die Risikoeinstufung „minimale bis keine Risiken“ verwenden werden.

Diese Modelle fallen nicht direkt unter den Einfluss des AI-Acts, doch ermutige die EU Organisationen, sich zu freiwilligen Verhaltenskodizes zu verpflichten, um ihr Risiko besser zu steuern, so Greifender. Sein dringender Ratschlag dazu lautet: „Es ist von entscheidender Bedeutung, dass sie diesen Ratschlag ernst nehmen, denn sonst könnten die Unternehmen feststellen, dass sie sich trotz ihrer 'Konformität' einem Risiko aussetzen.

„Unternehmen müssen ihre KI anhand ihrer eigenen Risikoparameter kategorisieren und mögliche Auswirkungen auf Umsatz, Reputation und Stakeholder-Beziehungen prüfen.“

Bei der Entwicklung ihrer eigenen Verhaltenskodizes müssten Unternehmen zunächst berücksichtigen, dass KI nicht gleich KI sei. Einige Technologien, etwa solche, die auf nicht-deterministischen Ansätzen wie der generativen KI basieren, seien mit größeren Risiken verbunden als andere, bewährtere Modelle. Daher müssten Führungskräfte ihre KI anhand ihrer eigenen Risikoparameter kategorisieren und mögliche Auswirkungen auf Umsatz, Reputation und Stakeholder-Beziehungen prüfen. Sie müssten zudem berücksichtigen, auf welche Art und Weise KI Entscheidungen treffe, ob sie transparent sei, auf welche Prozesse sie Zugriff habe und welche Prozesse sie kontrolliere.

Außerdem sollte ein Unternehmen feststellen, ob die Ergebnisse ihrer KI-Anwendungen deterministisch seien oder nicht. Das heißt, ob sie aus relevanten und kontextbezogenen Daten abgeleitet werden, die in Echtzeit aktualisiert werden und daher sehr genau sind. Oder ob die KI Schlussfolgerungen aus zufälligen und geschlossenen Daten ziehe, was sie anfällig für Fehler und Halluzinationen mache. „Ohne einen Klassifizierungsrahmen, der diese Merkmale klar abbildet, werden Unternehmen Schwierigkeiten haben, KI sicher zu nutzen - unabhängig davon, ob sie die Vorschriften einhalten oder nicht," warnt Greifeneder.